Видеокарта компьютера и ее предназначение

Видеокарта это то устройство, с помощью которого изображение выводится на монитор. Т.е. без видеокарты ни текста ни изображений мы на экране не увидим, и вообще, работа компьютера без видеокарты невозможна.

Есть два типа видеокарт: внешние видеокарты (дискретные) и встроенные (онбордные от англ. «On board» - на плате). Давайте вместе разберемся более подробно с этими понятиями. На рынке внешних видеокарт сейчас присутствуют два монополиста. Это Калифорнийская компания «Nvidia» и Канадская «ATI Technologies». В 2006-ом году последняя была выкуплена также американской компанией по производству процессоров «AMD» (Advanced MIcro Devices). Сейчас AMD активно продает свои графические ускорители под раскрученным ATI, в свое время, брендом «Radeon».

Вот как может выглядеть внешняя (дискретная) видеокарта начального уровня от ATI-AMD:

Цифрами на фото обозначены:

- Радиатор с охлаждающим вентилятором для GPU

- Разъем PCI-Express которым карта вставляется в материнскую плату

- (3-4) Видео выходы VGA и DVI соответственно (сейчас наблюдается массовый переход на новый цифровой стандарт - HDMI)

Примечание: GPU (Graphics Processing Unit или графическое обрабатывающее устройство) - сам графический процессор видеокарты (ее ядро).

Давайте более подробно: ядро видеокарты (в некотором упрощении) такая же микросхема, как и ядро центрального процессора. Только занимается оно своими специфичными задачами - выводом изображения (любого) на экран пользователя. Начиная от вывода текста и заканчивая обработкой трехмерных сцен любимой компьютерной игры.

Сам чип графического процессора на заводе (при помощи BGA метода монтажа) припаивается к текстолиту печатной платы внешней видеокарты (красная "пластмасса" на рисунке выше), сверху на него плотно (либо приклеивается, либо прикручивается) радиатор для отвода тепла и уже на сам радиатор - вентилятор (кулер - cooler) для рассеивания горячего воздуха. Как видите, конструктивно все это очень похоже на процессор с его системной охлаждения.

Внешняя видеокарта подключается к материнской плате через специализированный разъем (слот). Для каждого поколения видеокарт он свой (в зависимости от времени выпуска карты).

Данное утверждение справедливо практически для всего ассортимента компьютерных комплектующих. В данном случае, тут можно достаточно легко определиться чисто визуально "на глаз". Первые видеокарты устанавливались в ISA (Industry Standard Architecture) разъемы, на смену им пришел разъем PCI (Peripheral Component Interconnect - дословно: взаимосвязь периферийных компонентов), затем - AGP (Accelerated Graphics Port - ускоренный графический порт) и вот теперь мы имеем шину и, соответственно, слот PCI-Express. Причем разные ее версии (ревизии) физически и электрически совместимы между собой, а отличаются только пропускной способностью (шириной) шины данных, соединяющей видеокарту и материнскую плату.

Через видео выходы на карте происходит ее физическое подключение к монитору (или телевизору). Здесь, опять же, все зависит от поддерживаемого Вашим монитором/телевизором стандарта.

К примеру, VGA разъем (номер 1 на фото выше) передает сигнал в аналоговом виде. Стандарт DVI (цифра 2) подразумевает исключительно цифровую передачу сигнала (без дополнительных его преобразований). Новый же стандарт HDMI вместе с изображением по кабелю может передавать и звук. Аббревиатура HDMI расшифровывается как «High Definition Multimedia Interface» - мультимедийный интерфейс высокой четкости (высокого качества).

Думаю, основную мысль Вы уловили: смотрим что есть у нас (наличие каких выходов), сверяем с тем что хотим подключить на предмет "подойдет, не подойдет", думаем наличие каких разъемов нам может понадобиться в будущем - берем "на вырост" :) Ну и, конечно, не забываем про переходники, с помощью которых внешняя видеокарта может подключаться к устройству вывода изображения: DVI-VGA или HDMI-VGA (уже не переходник, а полноценный контроллер-конвертер видеосигнала).

Хотелось бы еще сказать пару слов о современных видеокартах, которым для работы требуется дополнительное питание, подающееся на них напрямую от блока питания компьютера.

Ситуация здесь следующая: любая внешняя видеокарта для компьютера (будь то стандарта PCI, AGP или же PCI-Express) получает питание непосредственно от разъема материнской платы, в который она установлена. К примеру, максимальная мощность в ваттах, которую может обеспечить разъем стандарта AGP составляет 42 Вт, PCI-Express версии 1.1 - 76 Вт (Ватт) соответственно.

Как Вы понимаете, многие современные внешние видеокарты (особенно при максимальных нагрузках) потребляют гораздо больше мощности. Именно из-за этого для них и придумали дополнительный разъем питания.

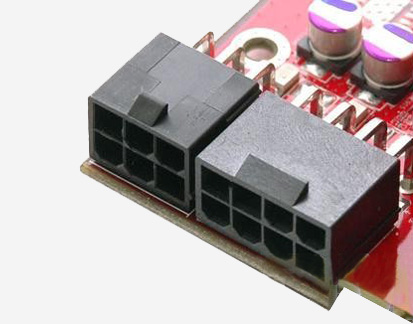

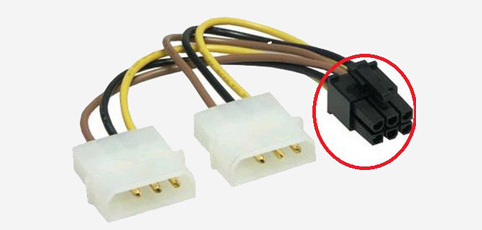

Вот как могут выглядеть эти разъемы:

В комплекте с таким графическим ускорителем обязательно должен быть специальный переходник, который соединяет один из стандартных «molex» разъемов блока питания и дополнительный вход питания карты.

У современных блоков питания подобные дополнительные разъемы присутствуют изначально, так что Вам не нужно будет заботиться о переходниках, но знать о такой возможности нужно! Современные графические ускорители (особенно это касается изделий от компании AMD) могут потреблять изрядное количество энергии (под 250 Ватт), так что учитывайте этот момент при выборе GPU и блока питания компьютера, который должен будет обеспечивать весь этот шик :)

Также заранее нужно подумать и о корпусе компьютера, потому как топовые карты могут достигать более тридцати сантиметров в длину и не в каждый системный блок их можно будет установить.

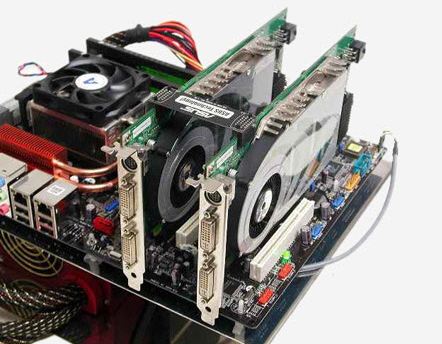

Если компьютер предполагается использовать в основном для игр или работы с трехмерной графикой, можно приобрести материнскую плату с несколькими разъемами «Pci-Express x16» под графические ускорители. Это позволит задействовать одновременно несколько внешних видеокарт одной модели. Что в сумме даст ощутимый прирост производительности графической подсистемы.

У компании «Nvidia» эта ее фирменная технология называется «SLI» - (Scalable Link Interface - масштабируемый интерфейс связи) и для кооперативной работы здесь нужны абсолютно одинаковые внешние видеокарты, ее прямой конкурент имеет аналогичную разработку, которая называется «AMD CrossFire» и здесь могут использоваться любые графические ускорители, поддерживающие данную технологию. Обе эти разработки позволяют объединять мощности нескольких внешних видеокарт и заставляют их работать, как одно целое.

Если надумаете организовать что-то похожее, имейте в виду что некоторые материнские платы могут быть "заточены" только под одну их этих технологий. Есть и универсальные и этот момент не лишним будет уточнить при покупке. Хотя, справедливости ради: так ли уж нужен режим объединения видеокарт для игр? Я в том смысле, что и одна внешняя видеокарта последнего поколения вполне справляется с любой современной игрой.

Во второй части статьи хотел бы поделиться своим опытом модернизации (апгрейда - upgrade) внешней видеокарты на своем домашнем компьютере. Что в этом интересного? Просто я подумал, что по ходу рассказа будут появляться некоторые новые понятия и описания, которые могут органично дополнить и углубить тему данной статьи. Если нет, то просто похвастаюсь приобретением! :)

Итак, до апгрейда у меня была установлена карта от компании Nvidia: «Asus GeForce 9600 GT» Вот так она выглядела:

Отличная карта, между прочим! Аппаратная поддержка DirectX10, 512 мегабайт видеопамяти, для того времени - очень достойно! Это моя первая внешняя видеокарта, которой требовалось дополнительное питание (6-ти контактный разъем справа). При пиковой нагрузке TDP карты могло приближаться к 96-ти Ваттам, а как мы помним, разъем Pci Express может обеспечить только 76, поэтому без дополнительного питания тут никак! Новый (на то время) 65-ти нанометровый техпроцесс. Видеокарта даже в моем не маленьком корпусе компьютера выглядела довольно внушительно. Скажу так: до этого момента я себя "игрушками" такого класса не баловал :) А дополнительное питание... лично я успокоил себя тем, что современные графические адаптеры, по видимому, просто не могут без него обходиться.

Примечание: TDP - «Thermal Design Power» или «Thermal Design Point» - примерно переводится, как конструктивные требования по теплоотводу. Иными словами, ожидаемая рассеиваемая мощность (количество тепла, выделенного или рассеянного в единицу времени - секунду). Цифра указывает на отвод какой тепловой мощности должна быть рассчитана система охлаждения изделия.

Но все течет, все меняется, а в компьютерной индустрии очень быстро, поэтому пришло время заменить и эту модель внешней видеокарты на более новую. Остановил свой выбор я, опять же, на продукции от компании NVIDIA, - «GeForce GTX 750 Ti», в основу строения графического чипа которой легла новая технология компании под названием «Maxwell». Видеокарта на аппаратном уровне поддерживает версию DirectX11.2, имеет два гигабайта быстрой оперативной памяти для GPU стандарта GDDR5 (Graphics Double Data Rate), сам чип произведен с использованием 28-ми нанометрового технологического процесса (размер одного транзистора кристалла = 28 нанометров). Короче говоря, все игры 2015-го года запускаются с ней на средне-высоких настройках.

Примечание: нанометр - одна миллиардная часть метра.

Почему я останавливаюсь на таких деталях столь подробно? Просто я хочу показать Вам, насколько не сравнимы (в плане производительности) между собой эти два графических адаптера разных поколений. И это логично: на «GTX 750 Ti» быстро работают те игры, которые даже не могли запуститься на «GT 9600», но прелесть здесь не только в этом :) Посмотрите на новую видеокарту в референсном дизайне:

Примечание: референсный дизайн - печатная плата и система охлаждения, разработанные производителем (в данном случае, - Nvidia). Партнеры (Asus, MSI, Gigabyte) имеющие свои производственные мощности, могут помещать графический чип на плату с набором других компонентов и устанавливать свою систему охлаждения.

Просто визуально сравните эти две внешние видеокарты (можно легко сориентироваться по выступающим за слот PciExpress частям) и Вы все поймете:

- У новинки НЕТ дополнительного питания (просто нет и все!) :)

- Полноценное современное графическое ядро на базе чипа NVIDIA GM107

- Два гигабайта быстрой памяти GDDR5

- Карта помещается в любой системный блок, так как в длину всего имеет 159 миллиметров!

- Референсной системы охлаждения вполне хватает для рассеивания выделяемого видеокартой тепла: ее TDP заявлен на уровне 60 Ватт. Да что я Вам говорю, еще раз посмотрите на этот кулер на фото выше :)

- Как результат сложения второго и третье пунктов - отменная производительность в играх 2015-го года

- Минимально рекомендуемый блок питания для ПК с этой видеокартой - 300 Ватт (для сравнения: рекомендации для моей предыдущей GT 9600 - 400 Ватт!) Устройство потребляет всего 60 Ватт электроэнергии... Обалдеть :)

Это и есть новая архитектура «Maxwell» во всей красе! По заверениям самих производителей, чипы выпущенные на ее основе потребляют, по сравнению, с графическими процессорами прошлого поколения вдвое меньше энергии, при возрастании производительности чуть ли не до 300%.

Конечно, как говорится: "каждый кулик свое болото хвалит", но даже невооруженным глазом видно, что на этот раз инженерам «Nvidia» действительно есть чем гордиться!

До этого, признаюсь, я думал что индустрия игровых видеокарт движется явно не по тому пути. Постоянно увеличивающийся TDP (потребляемая мощность) изделий начала приводить к тому, что блоком питания в 750 Ватт никого не удивишь, а на различных форумах уже мелькают посты навроде: "купил себе БП килловатник, думаю проблем не будет!" Конечно! Какие проблемы?! Только за свет будешь много платить (как будто небольшой электрический чайник постоянно в розетку включен), а так - никаких проблем :)

Чтобы продемонстрировать более наглядно к чему привела постоянная гонка наращивания мощностей и погоня за "попугаями" (количеством очков или рейтингом ускорителя в программах тестирования подобных "3DMark"), продемонстрирую несколько фотографий. Ниже представлен «AMD-Radeon-R9-290X» (при пиковой нагрузке только сама видеокарта может потреблять до 250 Ватт).

Как видите внешней видеокарте уже не хватает конструкции обычной системы охлаждения и используется ее улучшенная версия турбинного типа: вентилятор "прокачивает" воздух через радиатор системы охлаждения и дальше он выбрасывается за пределы корпуса через специальные отверстия на тыльной стороне карты. Чтобы ощутить весь "трагизм" ситуации, давайте посмотрим на еще одного представителя семейства карт от AMD - «Radeon-R9-295X2»:

Для этого двухпроцессорного графического ускорителя TDP составляет 500 Ватт! Рассеивать (язык не поворачивается сказать "тепло" - жар) этой "печки" призвана комбинированная жидкостная система охлаждения. Ага, давайте еще азот туда запустим (он тоже жидким бывает) :) Вот так все это безобразие выглядит в разрезе:

Как видим, первой одумалась именно компания «Nvidia». Вместо того, чтобы тупо наращивать мегагерцы и размер своих внешних видеокарт, они пошли по пути серьезной оптимизации уже имеющихся решений. Результат оказался блестящим! Снижение тепловыделения и энергопотребления при ощутимо возросшей производительности - браво, «Nvidia»! Ситуация мне чем-то напомнила прорыв, который совершила компания «Intel», выпустив на рынок центральных процессоров свой «Core 2 Duo». Тогда ее конкурент (та же компания AMD) вынуждена была в срочном порядке серьезно снизить цену на целый ряд своих продуктов, так как объективно не выдерживала конкуренции с новой технологией.

Конечно, возможно, AMD тоже одумается и скоро перестанет превращать персональные компьютеры пользователей в подобие Мартена, но что-то веры в это мало. Думаю, как всегда, просто цены снизят: видите, в любом случае мы - в выигрыше! :)

Итак, давайте с Вами немного поговорим о том, чем же так хороша технология «Maxwell»? Прежде всего тем, что открывает собой линейку энергоэффективный решений от компании «Nvidia» для мобильных систем (планшетов, смартфонов, игровых приставок, ноутбуков и т.д.). Если будет желание, почитайте о мобильных процессорах «NVIDIA Tegra» - очень интересно!

Политика компании, на данном этапе, заключается в следующем: разработать и оттестировать решение для мобильный устройств, а потом масштабировать его для высокопроизводительных настольных систем. В результате, все энергосберегающие технологии перекочевывают из мобильных решений в производительные графические ускорители, размер последних уменьшается, а производительность увеличивается. Если помните, во времена бурного развития Интернета первые компьютеры тоже были очень большими, а теперь мы можем разместить их на коленях или держать на ладони :)

Например, внешняя видеокарта на архитектуре «Maxwell» автоматически сократит свое энергопотребление до минимума в то время, когда Вы просматриваете на компьютере фильм или работаете в текстовом редакторе или наоборот, поднимет частоту ядра выше номинала, когда это будет нужно требовательному приложению (технология Nvidia GPU Boost).

Возвращаясь к "обновке" :) Я приобрел внешнюю видеокарту от компании MSI. Это тот же чип GM107 на Maxwell-е, но установленный на более массивную печатную плату с измененной (относительно референсного дизайна) элементной базой и системой охлаждения с использованием медных тепловых трубок. Полное название видеокарты выглядит вот так: «GeForce GTX-750-TI-OCV1», ее фото ниже:

Чем она отличается от эталонной разработки? Прежде всего, комплектующими повышенной надежности. Это связано с тем что в названии ускорителя присутствует вот такая аббревиатура - OCV1. Что такое V1 я точно не скажу (возможно, версия 1?), но вот ОС говорит о многом. А именно, что данная внешняя видеокарта поставляется с разогнанной (OverClocking) версией чипа. Вполне естественно, что для обеспечения стабильной работы ей нужна другая (более надежная) элементная база компонентов. Отсюда и увеличение длинны платы и больший размер вентилятора.

Все это при сохранении преимуществ новой технологии, перечисленных выше. К примеру, как я ни старался, но так и не смог нагреть свою карту программой «FurMark» даже до 70-ти градусов Цельсия (без нагрузки ее температура в разгар лета была примерно 31 градус!) Да, и дополнительного питания на видеокарте нет, правда появилось место для установки разъема под него, но за ненадобностью он так и не был распаян.

Если у референсной «GTX 750 Ti» базовая тактовая частота (Base clock) составляет 1020 MHz, а при задействовании технологии ее адаптивного повышения (Boost) - 1085 MHz, то в OverClicking (OC) решении она изначально составляет 1059MHz, а при бусте - 1137MHz. Существуют еще более экстремальный вариант от той же MSI (знаменитая серия с дракончиком). Решение для этой модели называется «GTX 750 Ti Gaming Edition» (игровая редакция).

Как видите, здесь все куда более серьезно: частоты еще больше увеличены, система охлаждения полностью переработана, но это, по сути, все та же "кроха", которую мы рассматривали в середине данной статьи :)

В принципе, я против любого (даже заводского) разгона! Теоретически любой разгон снижает общее время "жизни" устройства. И это логично: ему приходится все время работать в не штатных условиях. Приведу еще один пример: небезызвестная компьютерная игра «Ведьмак 3» от польской студии «CD Projekt» регулярно выдавала, как говорят геймеры, "фризы" - полное замирание картинки на несколько секунд, после чего все приходило в норму. Очень раздражает!

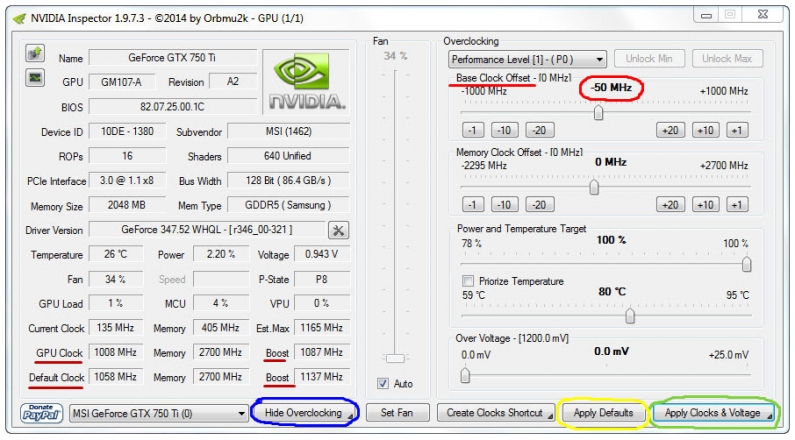

Помогла мне решить проблему утилита для тонкой настройки графических адаптеров семейства «Nvidia», которая называется «NVIDIA Inspector». Саму программу можно скачать с нашего сайта. Интерфейс разделен на два окна: в левой части отображаются текущие значения основных параметров устройства, а правая предназначена для их тонкой настройки.

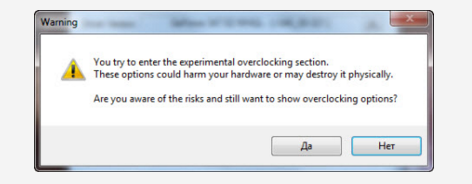

Нас будет интересовать кнопка «Show Overclocking» (показать настройки разгона), расположенная в правом нижнем углу. После нажатия на нее появится вот такое окно предупреждения:

В нем говорится, что все манипуляции, связанные с разгоном видеокарты мы совершаем на свой страх и риск и если она после этого перестанет работать, то разработчик софта не несет за это никакой ответственности! Солидарен с разработчиком :)

Просто нюанс состоит в том, что мы будем не увеличивать (разгонять) частоту графического ядра, а уменьшать ее! Нажимаем "Да", подтверждая тем самым что мы адекватные пользователи и сам себе админы. После этого нам дают доступ ко второму окну утилиты. Посмотрите на фото ниже:

Обратите внимание на значение «Base Clock Offset» (смещение относительно базового значения) в правой части окна программы. Там выставлено значение «-50» MHz. Именно минус пятьдесят! Т.е. мы уменьшили частоту графического ядра на 50 Мегагерц. После манипуляции со значениями не забудьте нажать на кнопку подтверждения изменений: «Appy Clocks & Voltage».

Примечание: в любой момент Вы можете вернуться к значениям по умолчанию, нажав на кнопку «Apply Defaults».

Посмотрите на левую часть окна и значения частот, выделенные красным цветом: «GPU Clock» и «Default Clock». Первое значение показывает текущую частоту графического адаптера, а второе частоту по умолчанию (заводское значение). Две другие цифры напротив под общим названием «Boost» показывают частоту GPU в режиме ее штатного повышения. Также текущий (верхний) и заводской (нижний) показатель.

Как видите, обе строки показывают снижение частоты на 50 Мегагерц - ровно столько, сколько мы и указали справа. Не знаю почему, но больше «Ведьмак 3» не "фризит" и я могу спокойно в него играть. Так что разгон - далеко не всегда благо!

Примечание: после того, как Вы закрываете программу, все произведенные изменения пропадают. Если они нужны, просто сверните приложение в трей.

Как альтернативу и именно для отображения информации о Вашем 3D ускорителе, могу порекомендовать бесплатную программу «GpuZ». Она показывает очень подробную информацию о GPU, На второй ее вкладке "Sensors" можно увидеть статистику загруженности ядра и памяти, скорость вращения вентилятора, температуру чипа и т.д.

Напоследок, хотелось бы дать несколько банальных советов тем, кто покупает видеокарты для игр, ведь чего греха таить, все мы любим иногда азартно "порубиться" в новый шутер или "зависнуть" в походовую стратегию. Прежде всего, внешняя видеокарта для игр не может быть выполнена на пассивном охлаждении (без вентилятора). В названиях таких решений обычно присутствует слово Silent (тихий) и подходят они для офисных компьютеров, но никак не для игровых.

Регулярно обновляйте драйвера на свой графический ускоритель - реально помогает. Помню, только одна эта процедура смогла существенно исправить ситуацию с проседанием FPS (Frame Per Second - количество кадров в секунду) в одной игре.

Также старайтесь покупать продукцию только хорошо зарекомендовавших себя производителей. В отношении видеокарт это могут быть все те же «AMD», «Asus», «Gigabyte», «MSI». Помню, была у меня долгое время отличная карта от «Sapphire» - ничего плохого сказать не могу или это мне так повезло? На этом пока все, следите за нашими другими статьями.